2021年7月14日,北京师范大学认知神经科学与学习国家重点实验室朱朝喆教授课题组在《Frontiers in Neuroinformatics》上发表了名为“NIRS-ICA: a MATLAB toolbox for independent component analysisapplied in fNIRS studies”的文章,介绍该课题组近期开发的面向近红外光谱脑功能成像(fNIRS)的ICA分析软件。

近红外光谱脑功能成像(fNIRS)是一种非侵入的光学神经影像技术,已经被广泛的应用到探索人脑的各种认知活动的研究中,包括任务诱发的神经活动以及自发神经活动。FNIRS具有便携,对头动不敏感和生态效度高的优点。基于这些优势,fNIRS很适合在自然场景中研究人脑功能,特别是同时记录人际交互时多个人的神经活动,即“超扫描”。同时还便于对如婴儿和老年人等无法扫描功能磁共振(fMRI)的特殊人群的脑影像研究。另外,fNIRS相比于功能磁共振(fMRI),有着更高的时间分辨率,能够更全面的反应神经活动伴随的血氧代谢变化的信息,有潜力使我们进一步理解神经血管耦合现象。

然而,fNIRS信号中除了神经活动相关的成分,还包含了各种生理和非生理的噪声成分。其中包括如呼吸,心跳,马亚波等生理噪声。同时,虽然fNIRS对头动不敏感,但在自然场景下,由于受试者的头动可能会使光极和头皮之间产生位移,导致在近红外信号中出现头动噪声。这些潜在的噪声成分严重的影响了fNIRS信号的信噪比。故去除噪声和提取神经活动相关的成分在fNIRS的研究中是很重要的。

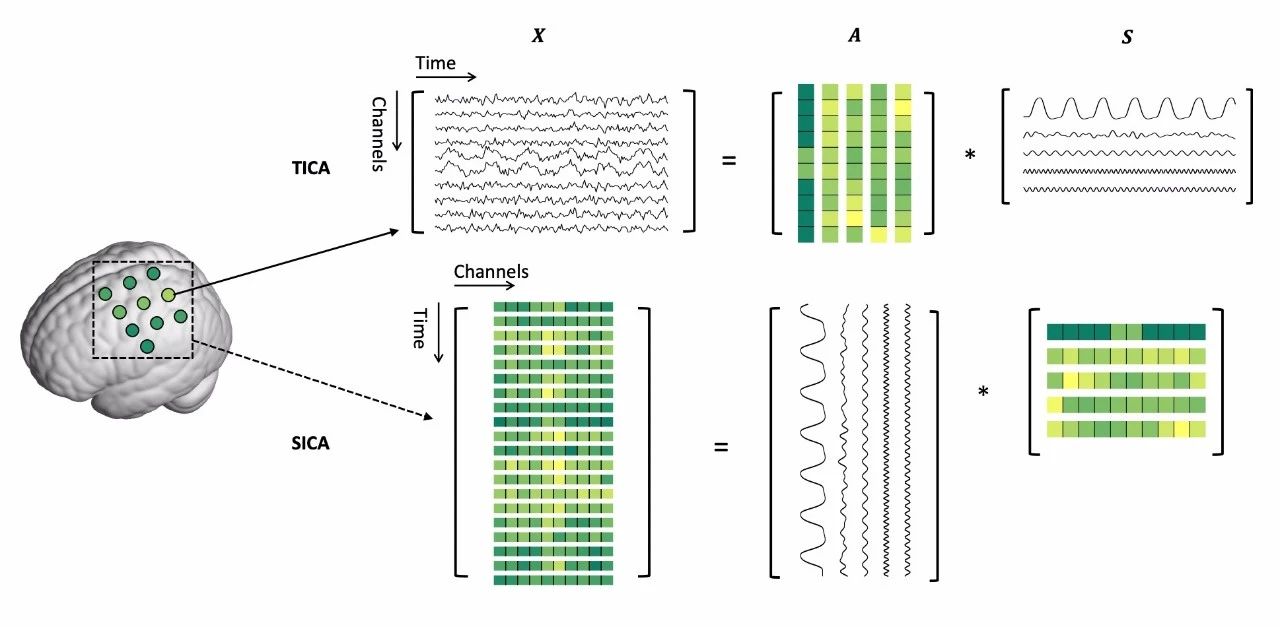

图 1. 时间或空间独立成分分析在fNIRS上的应用。

独立成分分析(ICA)是一种有效的去除噪声和提取神经活动的方法(图1)。已经被广泛的应用到fNIRS信号的降噪,或提取感兴趣的神经活动的研究中。然而,ICA使用较为复杂,在fNIRS领域中还没有一个开放的,用户体验良好的软件来支持ICA分析。因此,在该研究中,作者提出了NIRS-ICA软件包帮助ICA在fNIRS数据上的应用。NIRS-ICA支持fNIRS领域常用的ICA分解算法,有着用户友好的界面来帮助成分选择,既能够用于fNIRS信号的预处理去除噪声,也能够作为数据驱动的方法提取fNIRS信号中感兴趣的神经活动。另外,NIRS-ICA还提供了若干的指标支持量化评估分解出的成分,能够帮助用户以更定量的方式挑选成分。

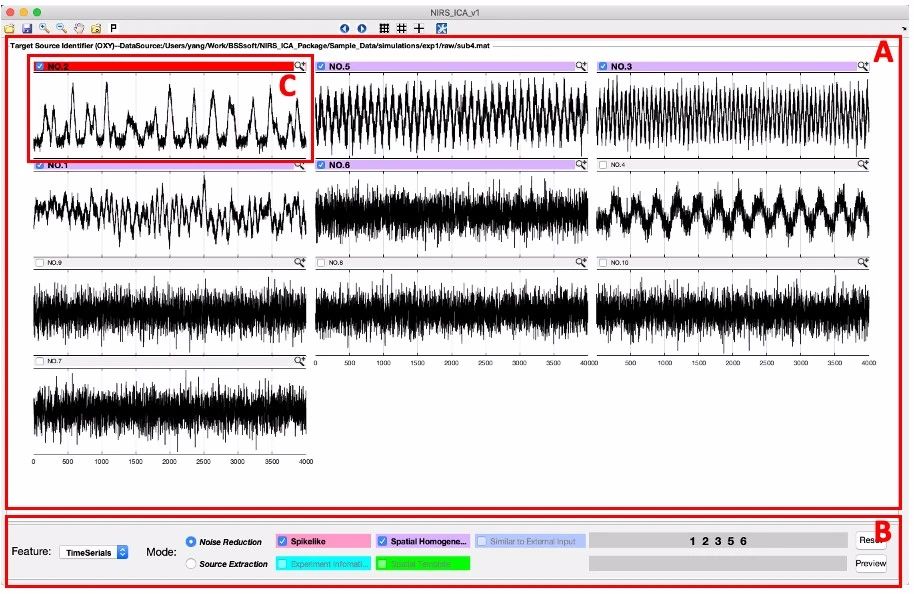

图 2.NIRS-ICA的主界面图。(A)ICA分解结果的显示面板,支持以格子的方式显示ICA分解出的成分。(B)显示控制面板,可供用户改变(A)中显示的源的特征(时间序列,空间模式,或频谱)、应用模式(噪声去除或提取感兴趣成分)和成分排序。(C)一个典型头动噪声成分的时间序列。

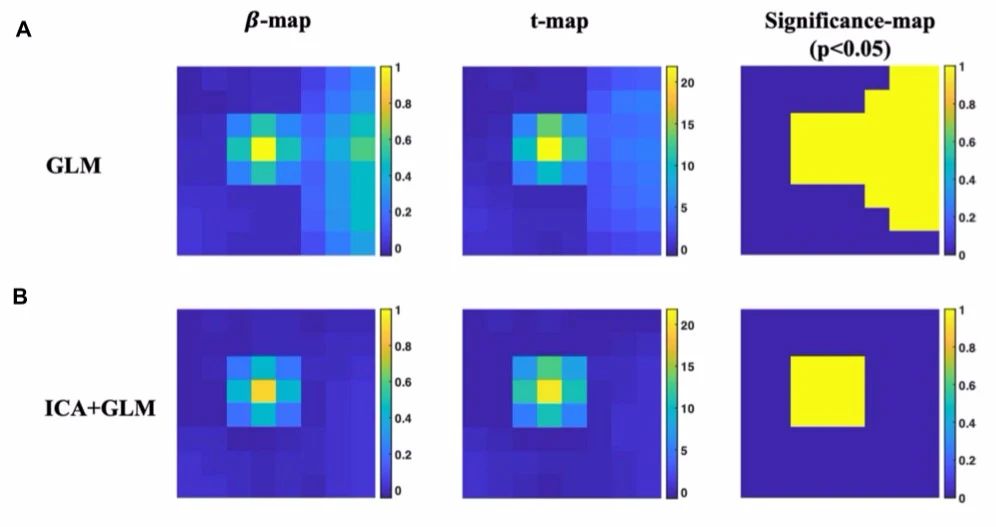

作者用模拟数据和真实实验数据(Finger-tapping任务)验证了NIRS-ICA的功能,并说明了其使用方法。模拟数据的分析结果显示,利用NIRS-ICA去除噪声后,激活区检测的结果(利用传统一般线性模型方法得到)具有更好的神经特异性(图3)。

图 3. 模拟实验的分析结果。(A)直接使用传统一般线性模型(GLM)分析得到的激活结果。(B)利用NIRS-ICA去噪后使用GLM分析得到的激活结果。

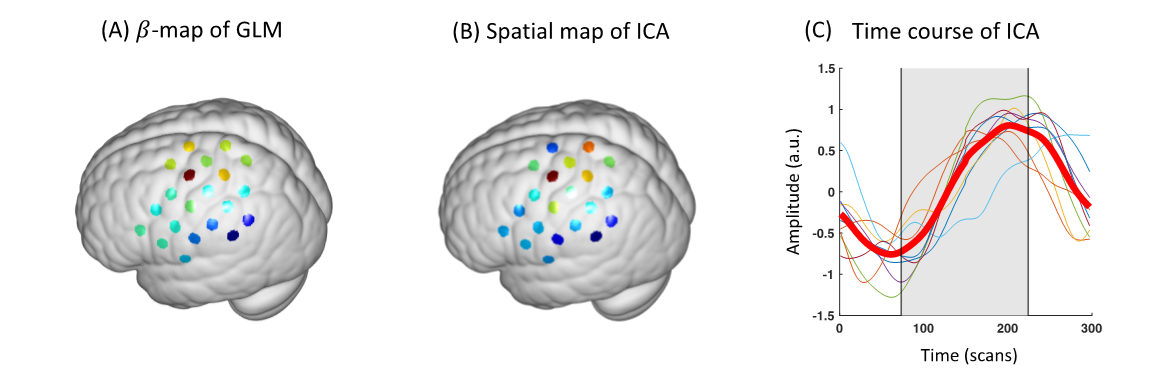

真实数据分析结果显示,利用NIRS-ICA能够在每个受试者的fNIRS数据中发现神经活动相关的成分,其平均的空间模式和传统分析方法(一般线性模型)相似,即最大值都出现在Ω区(图4A,B)。同时其平均的时间序列呈现出经典的血氧响应曲线(图3C)。这些结果都说明了NIRS-ICA能够有效的应用到fNIRS信号的噪声去除和提取神经活动相关的成分中。

图 4. 真实实验数据(Finger-tapping任务)的分析结果。(A)传统一般线性模型的激活图(值图)。(B)ICA结果的空间模式。(C)ICA结果的时间序列。

该论文的第一作者为博士研究生赵阳和孙沛沛,通讯作者为朱朝喆教授,来自北京师范大学认知神经科学与学习国家重点实验室。该研究得到国家自然科学基金重点项目,国家973项目等基金的支持。

该软件已经集成到课题组已开发的fNIRS分析工具包NIRS-KIT中,用户可通过访问http://www.nitrc.org/projects/nirskit/免费下载使用。欢迎大家使用,并提出宝贵意见。

论文信息:Zhao, Y.†, Sun, P.-P.†, Tan, F.-L., Hou, X. & Zhu, C.-Z. NIRS-ICA: A MATLAB Toolboxfor Independent Component Analysis Applied in fNIRS Studies. Front Neuroinform15, 683735 (2021).